Evalueringer

Lær at definere kvalitetsmetrikker og teste dit flow med automatiske evalueringer.

Adgang

- Udvikler, Anmelder, Administrator: Kan oprette og køre evalueringer

Oversigt

Evalueringssystemet giver dig mulighed for at:

- Definere kvalitetsmetrikker for dine flow-outputs

- Oprette testcases med specifikke inputværdier

- Automatisk score outputs mod definerede metrikker

- Gennemgå evalueringsresultater som anmelder

Måder at oprette metrikker:

- Skabelon: Vælg fra et bibliotek af foruddefinerede metrikker

- Beskriv: Beskriv hvad du vil tjekke med dine egne ord (dansk/engelsk)

- Generer med AI: Lad AI analysere dit flow og foreslå metrikker

- Manuel: Opret en metrik fra bunden

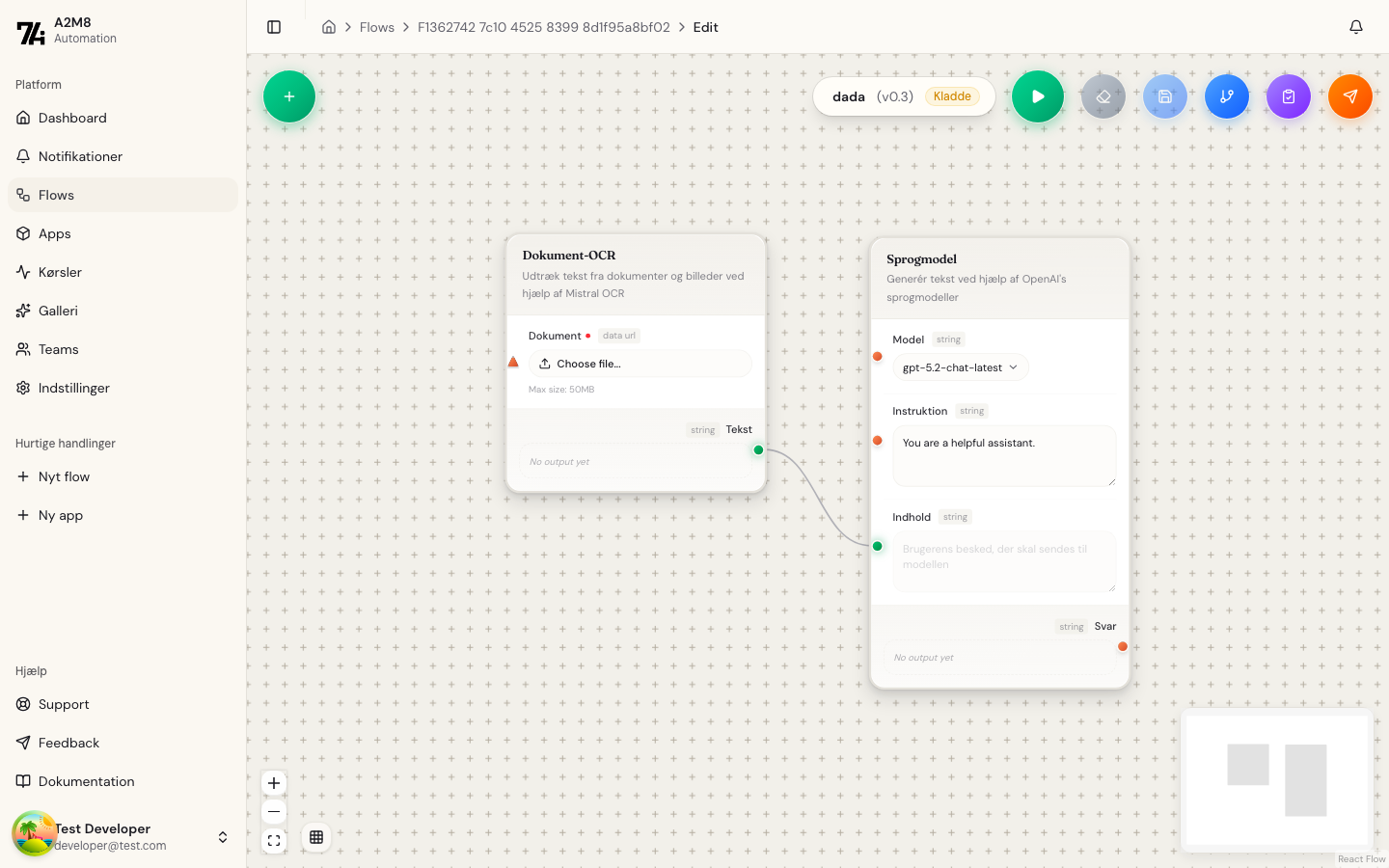

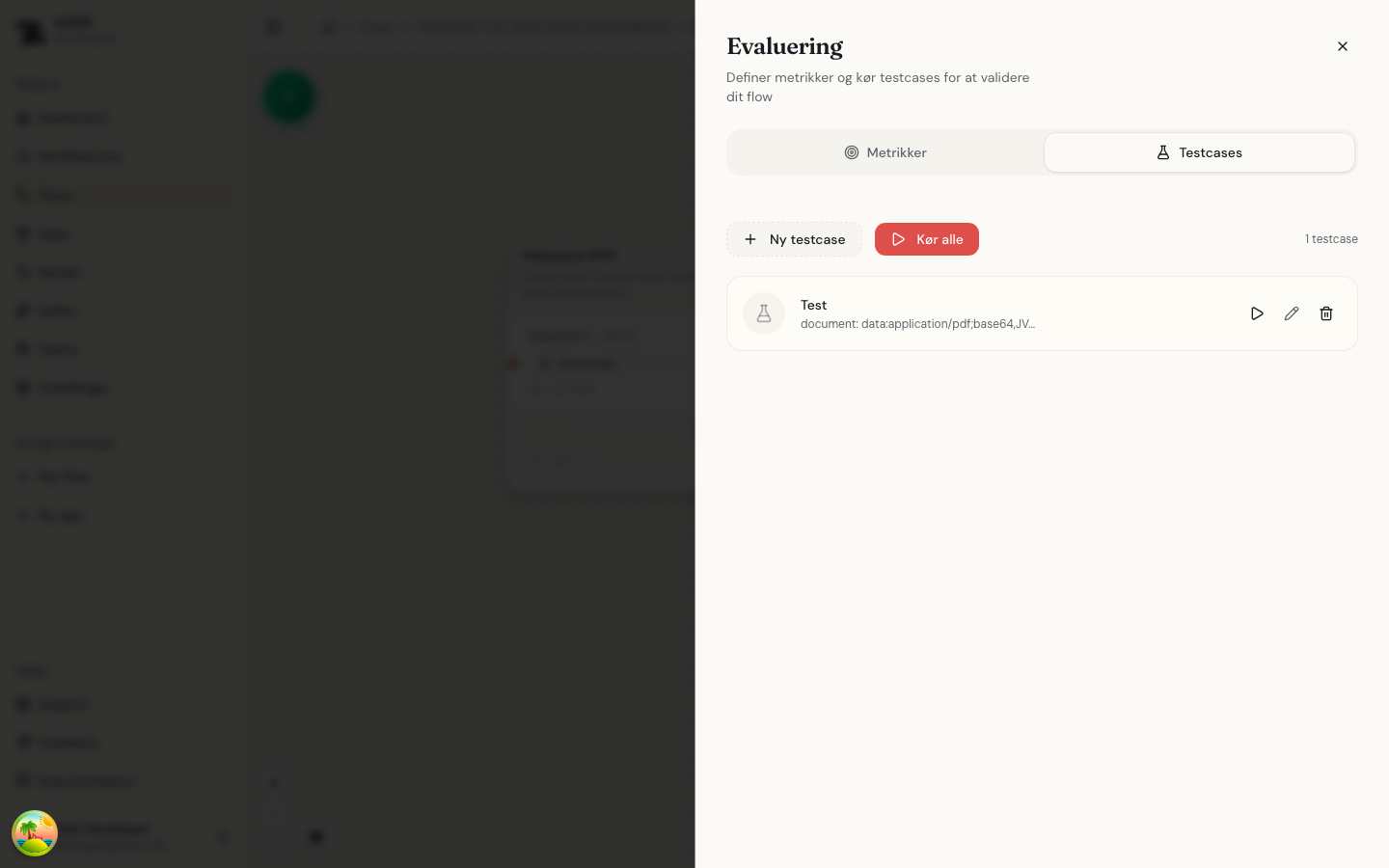

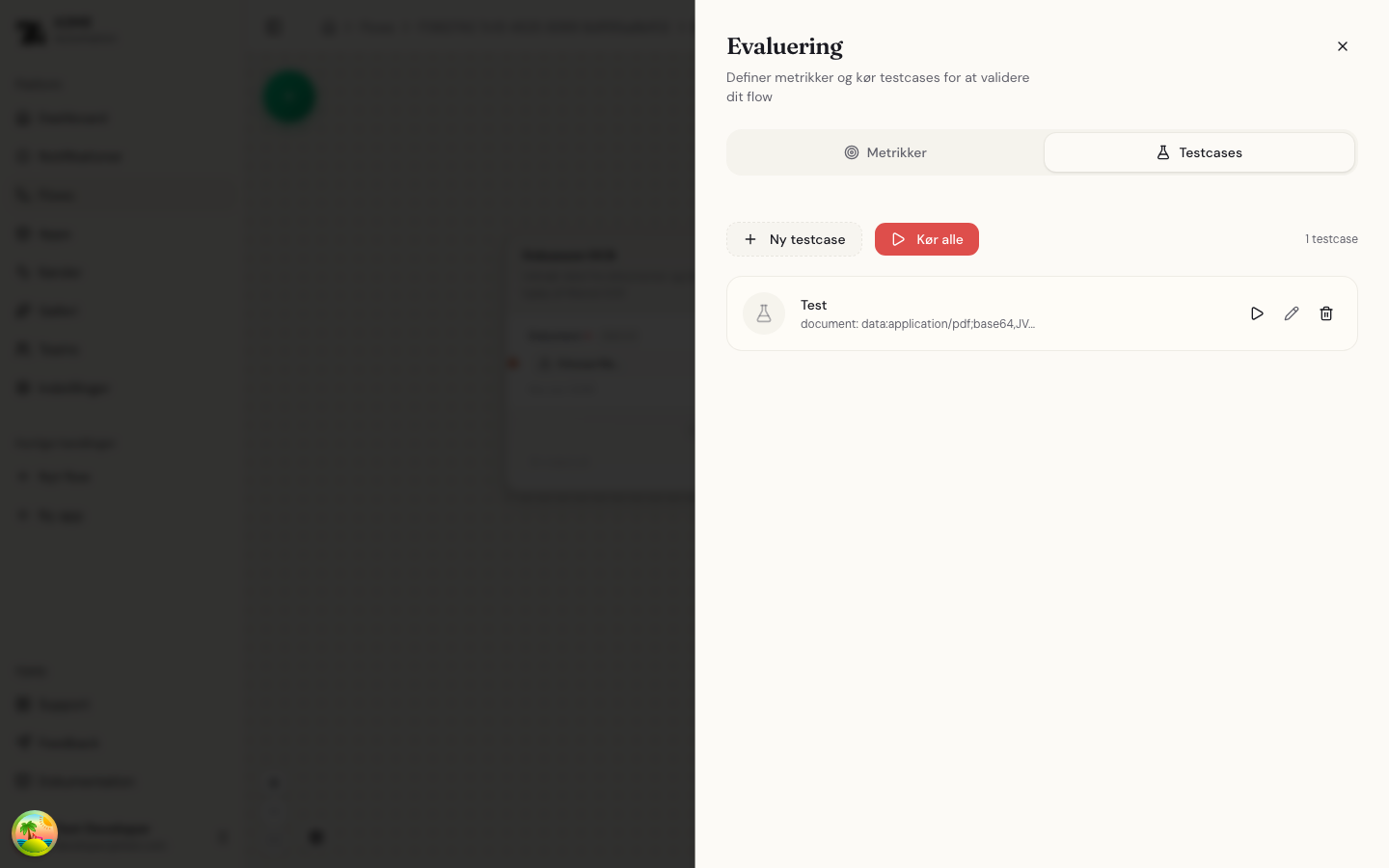

Åbn evalueringspanelet

Fra flow-editoren, klik på Evaluering-knappen (lilla clipboard-ikon) i værktøjslinjen.

Panelet har to faner:

- Metrikker: Definer kvalitetskriterier for dine outputs

- Testcases: Administrer testcases og kør evalueringer

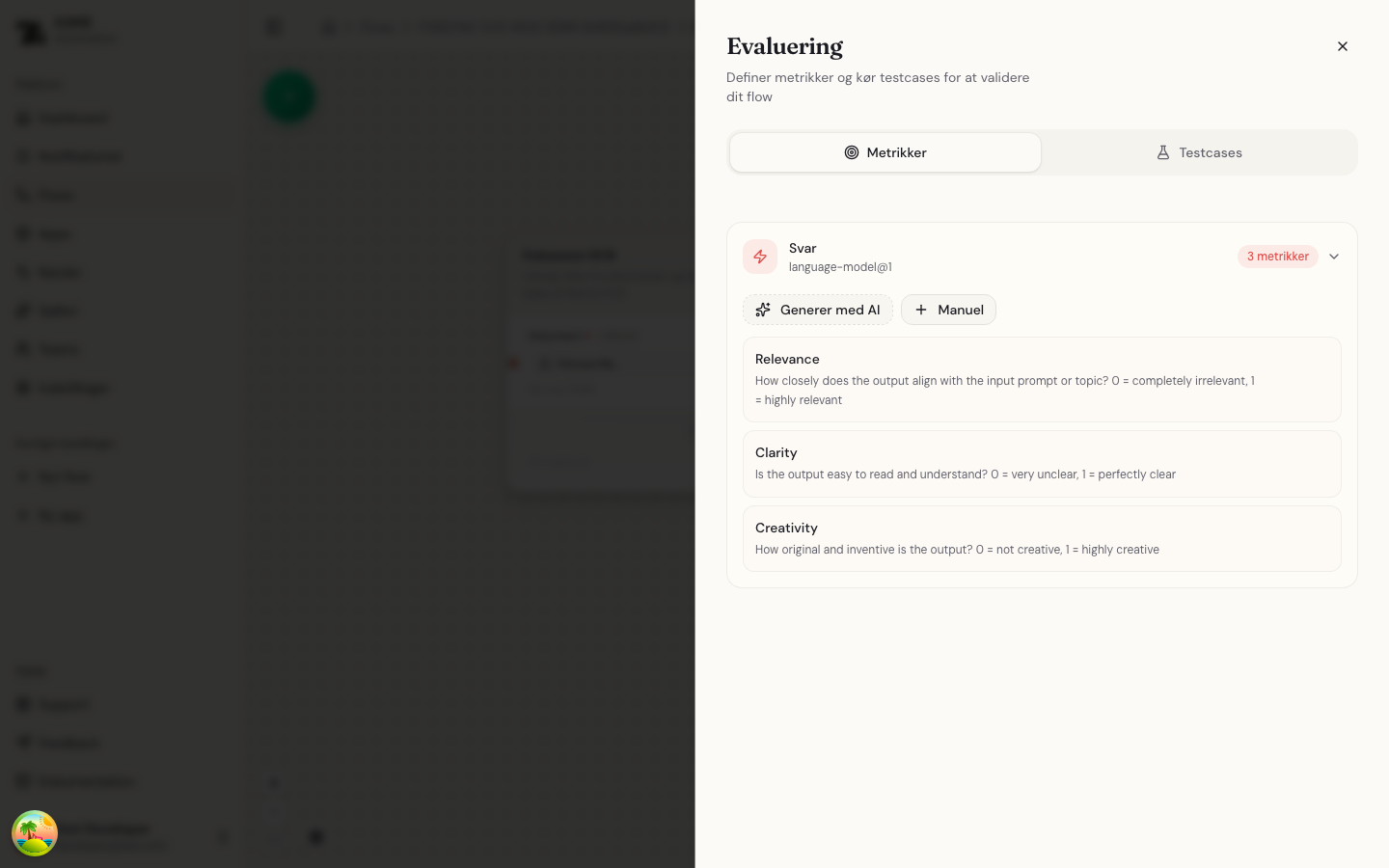

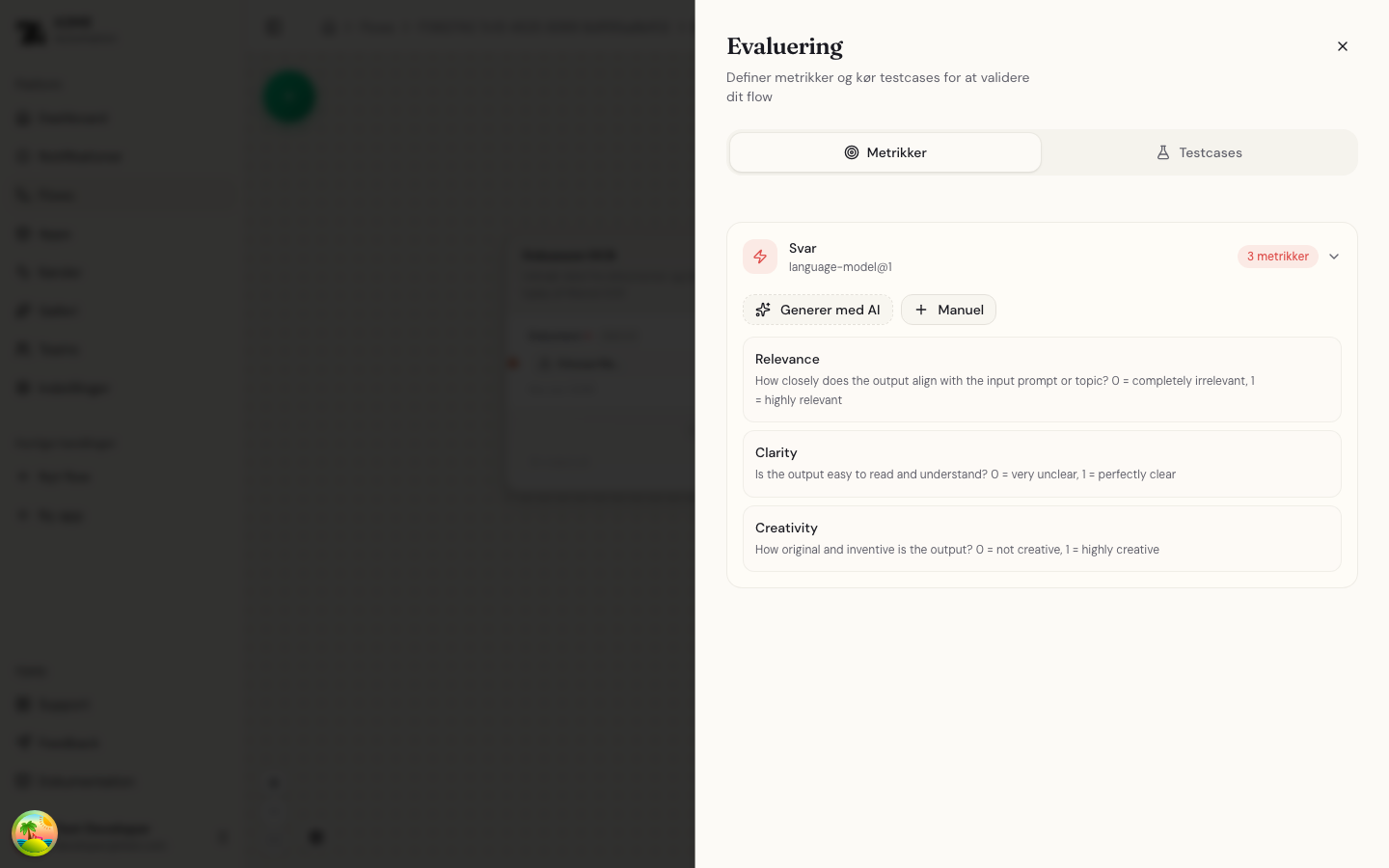

Metrikker

Metrikker definerer hvordan dine flow-outputs skal evalueres. Hver metrik er knyttet til et specifikt output fra en node.

Se metrikker

Metrikpanelet viser alle definerede metrikker grupperet efter output:

For hver metrik vises:

- Navn: Metrikkens identifikator

- Beskrivelse: Detaljerede kriterier for scoring (inkluderer scoringskala)

Opret metrik manuelt

- Klik + Manuel for at tilføje en ny metrik

- Vælg target-output (det node-output der skal evalueres)

- Indtast et metriknavn

- Skriv en detaljeret beskrivelse der forklarer scoringskriterierne

- Gem metrikken

Vælg fra skabelon

Klik Skabelon for at vælge fra et bibliotek af foruddefinerede metrikker.

Skabelonbiblioteket indeholder metrikker organiseret i kategorier:

| Kategori | Beskrivelse |

|---|---|

| Tekstkvalitet | Høflig tone, professionelt sprog, passende længde |

| Formatvalidering | Gyldig JSON, email-format, dato-format |

| Indholdscheck | Indeholder hilsen, nævner produkt, faktuel korrekthed |

| Struktur | Struktureret svar, JSON med påkrævede felter |

Funktioner:

- Foreslåede skabeloner: Systemet foreslår relevante skabeloner baseret på dit output (f.eks. JSON-skabeloner for API-outputs)

- Kategorier: Gennemse alle skabeloner organiseret efter type

- Tilpasning: Vælg en skabelon og tilpas den til dine behov

Beskriv med dine egne ord

Klik Beskriv for at oprette en metrik ved at beskrive hvad du vil tjekke på dansk eller engelsk.

Sådan fungerer det:

- Beskriv hvad du vil tjekke med dine egne ord

- AI genererer en passende metrik

- Forhåndsvis resultatet

- Accepter direkte eller rediger først

Eksempler på beskrivelser:

- "Tjek at svaret er høfligt"

- "Svaret skal være mellem 100 og 500 tegn"

- "Check the response contains a greeting"

- "Teksten skal indeholde en email-adresse"

Systemet vælger automatisk den simpleste evalueringstype der passer til din beskrivelse. For eksempel bliver "svaret skal være mellem 100 og 500 tegn" til en længde interval-metrik i stedet for en dyr LLM-evaluering.

AI-genererede metrikker

Klik Generer med AI for automatisk at oprette relevante metrikker for et output.

Systemet analyserer dit flow og foreslår passende evalueringskriterier. Dette er nyttigt når:

- Du er usikker på hvilke metrikker der skal bruges

- Du ønsker omfattende dækning af kvalitetsaspekter

- Du har brug for et udgangspunkt til tilpasning

Evalueringstyper

Metrikker kan bruge forskellige evalueringstyper afhængigt af hvad du vil tjekke:

| Type | Beskrivelse | Konfiguration |

|---|---|---|

| LLM | AI-baseret semantisk evaluering (standard) | Beskrivelse af kriterier |

| Indeholder | Tjek om output indeholder en specifik tekst | Forventet tekst, versalfølsom |

| Lig med | Tjek om output er præcis lig med en værdi | Forventet værdi (tekst, tal, boolean) |

| Regex | Tjek om output matcher et mønster | Regex-mønster |

| Længde interval | Tjek om output-længde er inden for et interval | Min/max længde |

| Gyldig JSON | Tjek om output er valid JSON | Valgfrit JSON-skema |

LLM-evaluering

LLM-evaluering bruger AI til at vurdere outputkvalitet baseret på beskrivelsen. Dette er ideelt til:

- Semantisk kvalitet (er svaret relevant?)

- Tonalitet og stil

- Komplekse kriterier der kræver forståelse

Deterministiske evalueringer

Deterministiske evalueringer er hurtige og billige (ingen LLM-kald). Brug dem til:

- Indeholder: Tjek for påkrævede nøgleord eller fraser

- Lig med: Validering af eksakte værdier (f.eks. "ja"/"nej" svar)

- Regex: Validering af formater (datoer, emails, telefonnumre)

- Længde interval: Sikre output er inden for forventet længde

- Gyldig JSON: Validere struktureret output

Deterministiske metrikker er 100% reproducerbare og koster intet at køre. Brug dem hvor muligt for format- og indholdsvalidering.

Scoringskala

Metrikker bruger en 0.0 til 1.0 scoringskala.

LLM-evalueringer kan give enhver score i intervallet:

| Score | Betydning |

|---|---|

| 0.0 | Opfylder slet ikke kriterierne |

| 0.2-0.4 | Opfylder delvist med væsentlige problemer |

| 0.6 | Opfylder de fleste kriterier med mindre problemer |

| 0.8 | Opfylder kriterierne godt |

| 1.0 | Opfylder alle kriterier perfekt |

Deterministiske evalueringer giver binære scores:

- 1.0 (100%): Kriteriet er opfyldt

- 0.0 (0%): Kriteriet er ikke opfyldt

Scores vises som procenter og farvekodes:

- Rød (0-39%): Dårlig performance

- Gul (40-69%): Acceptabel men kan forbedres

- Grøn (70-100%): God performance

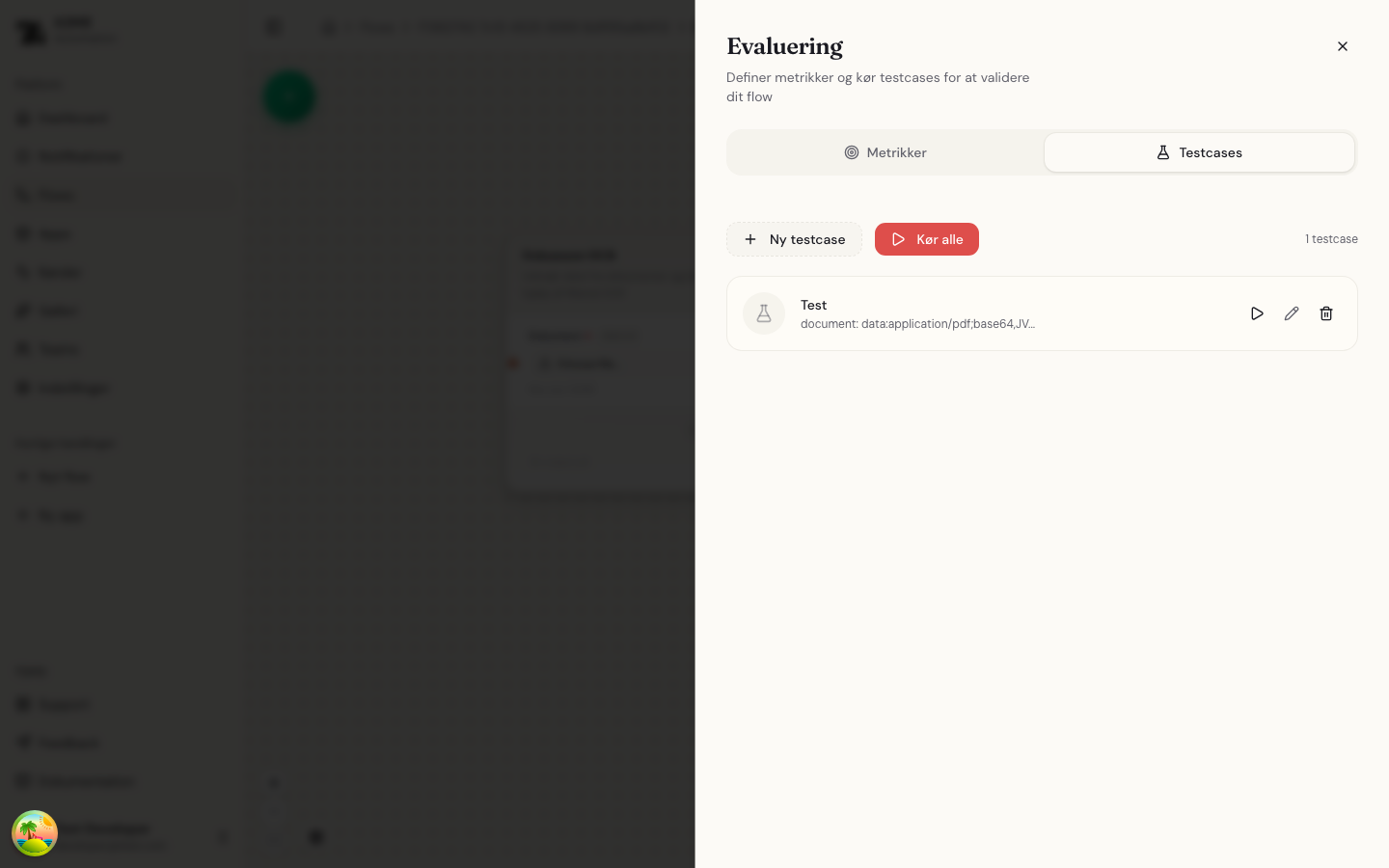

Testcases

Testcases definerer specifikke inputværdier til at køre gennem dit flow for evaluering.

Se testcases

Testcases-panelet viser alle definerede testcases med:

- Score-indikator: Cirkulært badge med gennemsnitsscore (hvis evalueret)

- Navn: Testcase-identifikator

- Inputværdier: Forhåndsvisning af inputparametrene

Opret testcase

- Klik + Ny testcase

- Indtast et beskrivende navn

- Udfyld værdier for hver flow-inputparameter

- Gem testcasen

Rediger og slet testcases

Hver testcase har handlingsknapper:

- Rediger (blyant-ikon): Ændre navn eller inputs

- Slet (skraldespand-ikon): Fjern testcasen

Kør evalueringer

Kør enkelt testcase

Klik afspil-knappen på en testcase for at:

- Køre flowet med testcasens inputs

- Score outputs mod alle definerede metrikker

- Vise resultaterne i den udvidede visning

Kør alle testcases

Klik Kør alle for at evaluere alle testcases sekventielt.

Dette er nyttigt til:

- Omfattende kvalitetskontrol

- Regressionstest efter flow-ændringer

- Sammenligning af performance på tværs af forskellige inputs

Se evalueringsresultater

Klik på udvid-pilen på en testcase for at se detaljerede resultater:

For hver metrik vises:

- Metriknavn: Hvilket kriterium der blev evalueret

- Score-bar: Visuel procent med farvekodning

- Begrundelse: AI-genereret forklaring af scoren

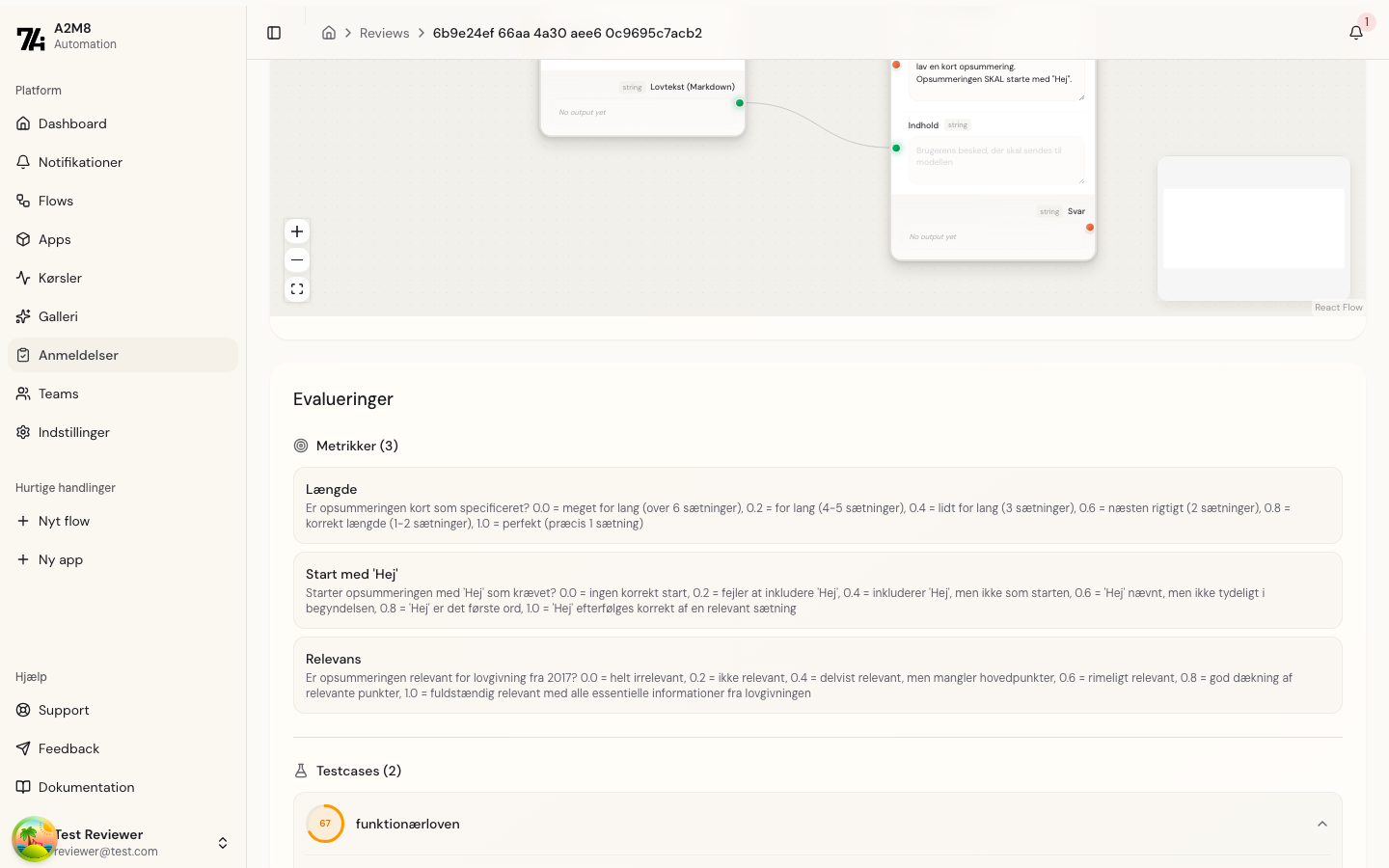

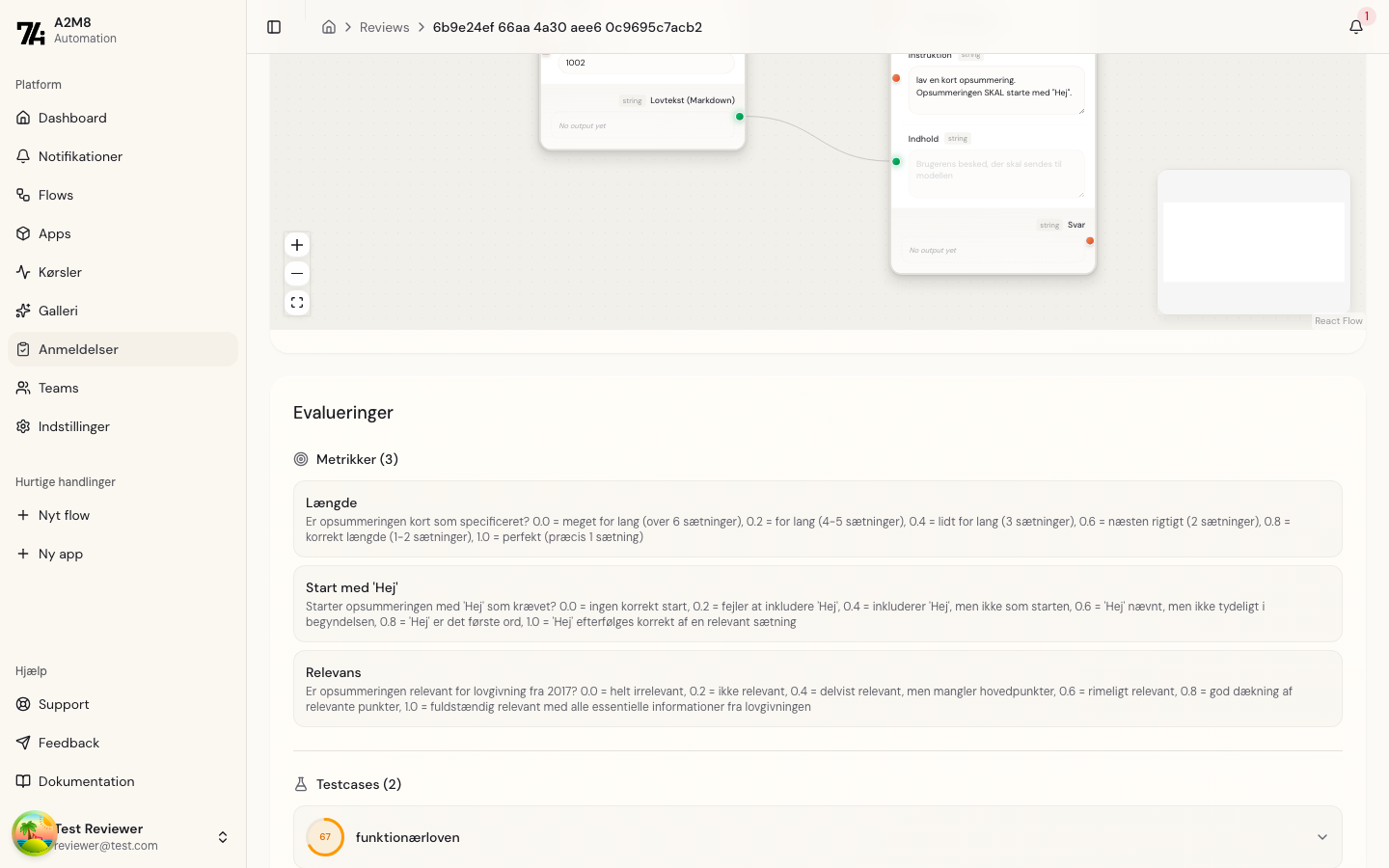

Evalueringer for anmeldere

Når du gennemgår en flow-indsendelse, vises evalueringer inline på anmeldelsessiden.

Metrikoversigt

Anmeldelsessiden viser alle definerede metrikker med deres fulde beskrivelser.

Testcase-resultater

Testcases vises med udvidelige kort:

- Klik for at udvide og se detaljerede scores

- Farvekodede score-indikatorer viser overordnet performance

- Individuelle metrikscores med begrundelse vises

Dette giver anmeldere mulighed for at:

- Hurtigt vurdere overordnet kvalitet fra score-badges

- Dykke ned i specifikke metrikker for detaljeret analyse

- Træffe informerede godkendelses-/afvisningsbeslutninger

Best practices

Vælg den rigtige evalueringstype

| Scenarie | Anbefalet type |

|---|---|

| Tjek for påkrævet nøgleord | Indeholder |

| Validere ja/nej svar | Lig med (boolean) |

| Tjek email- eller datoformat | Regex |

| Sikre svar ikke er for langt/kort | Længde interval |

| Validere JSON API-respons | Gyldig JSON |

| Vurdere kvalitet eller relevans | LLM |

| Tjek tonalitet eller stil | LLM |

Design effektive metrikker

- Vær specifik: Definer tydeligt hvad der udgør hvert scoreniveau

- Fokuser på ét aspekt: Hver metrik bør evaluere én kvalitetsdimension

- Inkluder eksempler: Referer til specifikke forventede adfærd i beskrivelser

- Dæk nøglekrav: Sørg for at metrikker adresserer alle kritiske kvalitetsaspekter

- Brug deterministiske først: Valider format og indhold med billige checks før dyre LLM-evalueringer

Opret gode testcases

- Dæk edge cases: Inkluder grænsetilfælde og usædvanlige inputs

- Repræsenter reel brug: Brug realistiske inputværdier

- Test variation: Inkluder forskellige inputkombinationer

- Navngiv beskrivende: Brug navne der indikerer hvad der testes

Fortolk resultater

- Se på trends: Sammenlign scores på tværs af flere testcases

- Læs begrundelser: AI-forklaringer giver handlingsorienteret indsigt

- Prioriter rettelser: Fokuser på metrikker med konsekvent lave scores

- Iterér: Kør evalueringer igen efter forbedringer af flowet

Fejlfinding

Ingen evalueringsresultater

Hvis en testcase ikke viser scores:

- Tjek at metrikker er defineret for flow-outputs

- Kontroller at flowet kørte succesfuldt

- Verificer at testcasen har gyldige inputværdier

Uventede scores

Hvis scores ikke matcher forventninger:

- Gennemgå metrikbeskrivelsen for klarhed

- Tjek om outputtet matcher hvad metrikken forventer

- Overvej at justere metrik-kriterierne